马斯克的“民有、民治、民享"理念和行动计划

本文摘自谢熊猫君翻译的蒂姆·乌尔班Tim Urban的文章第六章:大融合

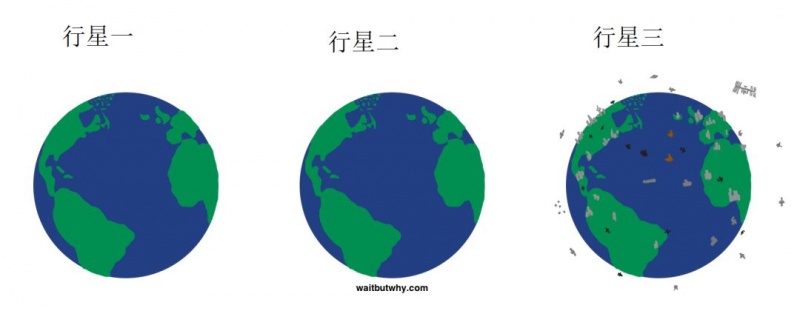

想象一个外星探索者来到一个新的恒星系,然后发现这个恒星有三颗行星,每颗行星上都有生命。

第一颗行星和公元前一千万年的地球一模一样

第二颗行星和公元前五万年的地球一模一样

第三个行星和2017年的地球一模一样

这位外星人并不是原始生命方面的专家,但它还是绕着三颗行星转了一圈,并用望眼镜观测了一下。第一颗行星上有很多水、树和山,还有一些动物生命的迹象。它在非洲大草原上看到了一群大象,海洋表面看到了一群跃起的海豚,还有一些零散分布的小动物。

然后它来到了第二颗行星看了一下,小动物多了点,但并没有多很多。它注意到了一个之前没有的东西,那就是偶尔大地上会出现一些火光。

看的无聊了,于是它来到了第三颗行星。哇!它看到了飞机在大地的上空穿梭,大片灰色的土地布满了高耸的建筑,海面上航行着各种船只,陆地上有横跨整个大洲的铁路,它还差点和一颗飞掠过的卫星撞起来。

它回家后,向别人这么报告它的发现:“两个行星上有原始生命,第三个行星上有智能生命。”

我们可以理解它为什么会得出这个结论,可惜这个结论是错的。

事实上,比较特别的是第一颗行星。第二和第三颗行星上都有智能生命,而且这些智能生命是一样聪明的。如果把行星二上的一个初生婴儿和行星三上的一个初生婴儿调换,这两个婴儿都会在各自的新星球上正常长大,无缝的融入身边的环境,他们是一样的人类。

但为什么会这样呢?

因为人类巨灵啊!

你平常是不是会为身边人类的平庸感到无趣,但是又为全人类的成就感到自豪呢?

这是因为,本质上,人类还是那些行星二上面的人。

把一个人类婴儿丢给一群猩猩像人猿泰山一样抚养,这个长大后的婴儿会在森林里穿梭,会爬树,会寻找食物,也会自慰。而我们每个人,其实就和这个婴儿是一样的。

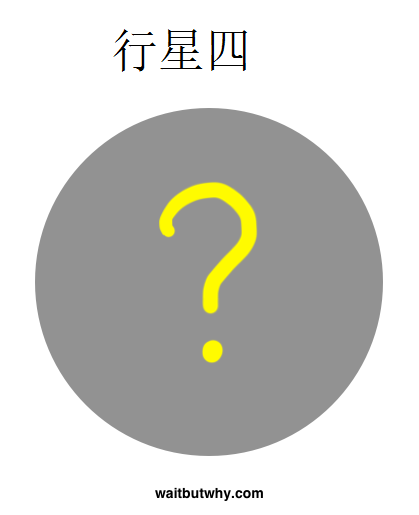

全人类,则是一个超级智能、知识渊博、几千年养成的巨灵,巨灵有75亿个神经元(每个神经元是一个人类个体)。建造行星三的,其实是这个巨灵。

语言的发明让每个人在死前都能把自己的知识汇总起来,汇总的知识越堆越高,直到有一天知识的高塔变成了建设文明的人类巨灵的脑。然后人类巨灵就开始不断的发明新事物,并且越来越熟练。巨灵的核心驱动力是创造价值,而现在他正以前所未有的步伐在往前迈进,这也是为什么我们现在活在一个前所未有的神奇的历史时刻。

还记得前面提到的,我们可能活在两个交流纪元的分界线上吗?

事实上,我们处在很多历史的分界线上。经过了十万年的人类历史,二十一世纪好像是地球生命从单行星纪元往多行星纪元跨步的时候了。这个世纪,一个地球种族也许能够摆脱生物演化的力量,把基因改造的工作抓到自己手里。当今的人类,可能会见证生物技术把人类寿命从自然意志中解放出来,交回到每个个体手中。

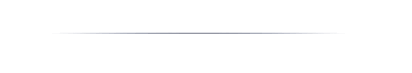

人类巨灵达到了前所未有的高度,它的力量能够颠覆38亿年的历史,把我们放到了多个无法想象的变革的临界点上。如果我们的外星探险家发现了一个和2100年的地球一模一样的行星四,我敢保证它和行星三完全不同。

我希望你喜欢行星三,因为我们将要离开它了。不管我们愿不愿意,行星四才是我们要去的地方。

要总结一下埃隆马斯克做的所有事情背后的一个共同主题,其实不难:

他想要让我们为行星四做好准备。

他活在大局观之中,他只会从最宏观的视角去看事情。这就是为什么他是个与众不同的梦想家,也是为什么他如此着急。

他并不是觉得行星四肯定不是个好地方,而是他觉得行星四有可能是个坏地方。他还意识到,现在活着的几代人,不管他们自己有没有意识到,将是首批在人类历史上真正面对生存危机的人。

同时,现在活着的几代人,也是首批有真实可能过上乌托邦生活的人——这个乌托邦甚至可能不存在死亡和税收,行星四可能是我们的应许之地。

当你从很宏观的视野来看这一切的时候,你会发现这次的赌注是难以企及的高。

而赌局的结果不是由概率决定的,而是由人类巨灵的意志来决定的。行星四的到来肯定是因为人类巨灵把它建造了出来,而行星四是天堂还是地狱,取决于人类巨灵在接下来一段时间是怎么做的,而这段时间可能是150年,可能是50年,也可能只有25年。

不幸的是人类巨灵并不擅长把尽量多的人类尽量安全的转移到一个尽量好的行星四上,人类巨灵只擅长把行星四以任何方式最快的造出来。

了解了这些后,埃隆马斯克将自己的生命专注于影响人类巨灵,让人类巨灵的驱动力尽量接近人类的长期利益。他知道他无法重塑人类巨灵,除非生存危机突然直接出现在了每一个人类的面前,而这种情况发生的时候通常已经太迟了。所以他决定把人类巨灵当做一只宠物。

如果你想要你的宠物狗学会坐姿,你会让它对坐下的指令和获得小奖励产生关联。对于人类巨灵来说,小奖励就是一个供应和需求同步爆发的新产业。

埃隆马斯克看到人类巨灵不断把深埋地底的碳排放进碳循环中,他没有请求巨灵不要排放碳(很多人浪费口舌的在这样做),也没有威胁巨灵好好爱护环境(很多政府试着这么做,成功有限),他造出了一款酷炫的人人都想要的电动车。汽车产业看到了客户需求的偏移,于是在特斯拉发布第一辆电动车之后的九年,大牌车厂从几乎没有一家做电动车到现在几乎每家都在做。巨灵收到了小奖励,而它之后的表现也会随之改变。

埃隆马斯克发现虽然很多变革的临界点快要到来,但是人类还是把自己的一切都押宝在地球上,于是他创立了SpaceX来研究火箭着陆。这项技术会把太空旅行的成本降低99%,使得把资源投入到航天产业变成巨灵的香饽饽。他的火星计划不是要试图说服全人类在火星建立一个文明来为人类种族存续上个保险,而是为了建立廉价的能够常规穿梭在火星和地球间的货船。只要这一步达成了,在巨灵的眼中,火星将会充满了创造价值的机会。

但是对于埃隆来说,人类巨灵做的所有事情中最可怕的就是教计算机巨灵思考。对于埃隆和其他很多人来说,研发超人工智能是迄今为止人类可能面对的最大的生存危机。

要认识到这点并不难,智能使得人类能够像神一样统治其它所有地球生物,而这对于其它生物来说不是个很好的体验。一个动物的任何身体部位只要有价值可以被创造,就会有大型的人类产业处理和贩卖那些身体部位。我们有时为了娱乐的目的杀死动物。

但这一切对我们来说其实并没有太多乐趣,我们只是在根据自己的理论走自己的路,我们内心并不仇恨或者想要伤害其他生物,只是这些生物和这个生态环境总是会挡着我们的路,而我们的行为有时会伤害到这些生物和生态。人类总是对自己的这种行为感到恼火,但是我们只是做了任何一个种族都在做的事情——利己。

其它生物面对的麻烦不是我们的利己心态,而是我们对其它生物有那么大的统治力,而这份统治力来自我们的智能优势。

对于刻意创造可能会拥有比我们高(甚至高出很多)的智能的东西,充满警惕是完全符合逻辑的。尤其这还是人类第一次做这样的事情,没有案例可寻也没有经验可谈。

而这个事情的进展还相当快,埃隆马斯克谈到了谷歌的围棋人工智能阿尔法狗:

“你看,阿尔法先是4:1击败了李世乭,然后现在它能和最厉害的50个棋手下棋,并且每盘都能赢。这中间也就一年时间。”

“现在这个进度只是在阿尔法狗这个人畜无害的东西上面,但是人工智能可以胜过人类的自由度范围在增加,(原本人工智能还只能下赢国际象棋),而围棋可比国际象棋的自由度大点,如果你让人工智能玩英雄联盟或者Dota 2这些自由度比围棋更大的即时战略游戏,它一时还比不过人类,但是它早晚会超过人类的。然后就是现实生活了,这是自由度最高的系统。”

因为上面提到的原因,这些事情让他很担忧:

“过去几年我开始意识到,人工智能很显然会超越人类智能很多。在未来的某个时候,风险会因此爆发,这是我们无法控制的,是人类无法控制的。而这个爆发点过后,要么是一小撮人垄断了人工智能的力量,要么是人工智能叛变,或者其它类似的情况。这些事也许不会发生,但是它们是有发生的可能性的。

但在人类巨灵的角度来说,

“集体意志并不因为人工智能的危险而转移。”

2015年当我采访埃隆 马斯克的时候,我问他是否会参于建造超级人工智能,他回答说:“我的真实想法是我们不应该造出一个超级人工智能。”而当我之后提到,建造一个比自己聪明的东西好像确实是个达尔文错误(我从Nick Bostrom那里借鉴了这个词),埃隆回应道:“我们会因此集体赢下达尔文奖的。”(注:达尔文奖奖励“通过愚蠢的方式毁灭了自我,为达尔文理论做出深远贡献”的人)

两年后的今天,他是这么说的:

“长久以来我一直我试图提醒大家关于人工智能的危险,但是显然没什么用(苦笑),所以我决定我们只能帮助人工智能往好的方向发展了。”

他接受了现实——人类巨灵会一直努力唤醒计算巨灵,直到它真的醒来的那一天。这是正在发生的事情。

不管别人怎么说,没人知道计算机巨灵学会思考后会发生什么。在我之前关于人工智能的长文中,我谈到了两种观点,一种认为超级人工智能会帮我们解决所有问题,另一种认为我们就是一群把我们不懂的炸弹当玩具玩的小孩。

我至今还不知道我究竟更偏向哪一边,但是为了最坏的可能性做好准备,做一切能提高我们生存机会的事情,是比较理性的做法。很多专家认同这种逻辑,但是现在对于建造安全的超级人工智能并没有一个共识,有的只是一群自认不知道答案的人给出的意见。是啊,谁又会知道怎么为一个他们不能理解的未来做好防护措施呢?

埃隆马斯克承认他也不知道答案,但是他正在策划一个能给我们最大胜算的计划。

埃隆马斯克的计划

阿伯拉罕.林肯说出下面这句话的时候相比是蛮得意的:

“民有、民治、民享的政府永世长存”

这句话确实写的不错。“民有、民治、民享”是民主的核心思想。

可惜,“民”不是那么让人愉快,所以民主也常常不是那么愉快,当然这种不愉快和其它选择比起来还是好很多的,埃隆 马斯克是这么说的:

“保护集体很重要。丘吉尔说过民主是所有政府体系中最不坏的。如果你有柏拉图的贤者王做国王当然好。可惜大部分的独裁者不是贤者王,相反的,他们都很糟糕。”

也就是说,民主就好像躲在阴沟里逃避野兽一样。

在人生中,有很多时候可以冒险赌一下最好的结果,但是当赌注无比的高的时候,正确的做法其实是保守一点。权力就是这样的一种情况,所以虽然民主本质上会带来一定程度的平庸,但是按照埃隆的说法“不管大家对一个总统多不满,你在美国估计找不到多少人愿意由一个独裁者来取而代之。”

既然埃隆把人工智能看作最终的权力,他把人工智能的研发看作一个必须要“保守一点”的情况。所以他对于最小化人工智能带来的生存危机的策略是人工智能的力量应该是“民有、民治、民享”的。

为了在人工智能领域推广这个概念,埃隆从多个角度切入。

对于民治和民享的部分,他和Sam Altman建立了OpenAI,一个“非盈利性的人工智能研究公司,致力于发现和建立通往安全的人工智能的道路。”

通常,当人类做一些新鲜事情的时候,最开始都是一些有创新意识的先驱们带头,当他们获得成功后,一个新的产业就建立了,人类巨灵就会进入其中,把先驱们建立的东西作为基础,发展壮大。

但是如果这些先驱做的是创造一个拥有无比统治力量的魔法棒,而且这个魔法棒还能防止其他人造出类似的魔法棒,那就有点不好办了,是吧?

而这其实就是埃隆对于现在的早期人工智能研发的看法。既然他不能阻止人们研发魔法棒,他的解决方法就是建立一个开放、合作、透明的魔法棒研发实验室。每当实验室发现一个新东西时,他不是像其它公司一样把这个新发现私藏起来,而是把发现公开给所有人知道,供其他研发魔法棒的人借鉴。

这样做当然存在问题,因为坏人也在造魔法棒,而你肯定不希望坏人最先造出魔法棒来。但是现在的情况是,坏人也能从这个实验室公布的发现中获益。这是个挺严重的问题。

但是这个实验室同时也助力了其他数百万想要做魔法棒的人。这给那些秘密研究的行业先驱们造成了很大的竞争压力,使得没有哪个发明家能比其他任何一个人早很多的造出魔法棒。最可能的结果是,当第一个魔法被造了出来的时候,还有其它成千上万个不同人出于不同目的制造的功能不用的魔法棒也快造完了。

如果魔法棒的出现不可避免,那么埃隆认为,至少让很多人都有魔法棒,而不是只有一个人有着无边的法力。他是这么说的:

“如果每个人都来自氪星,那再好不过。但如果只有一个人来自氪星,也就是只有一个超人,而超人恰巧和希特勒一样坏,那我们就麻烦了。”

更宽泛的说,单个先驱的魔法棒可能是造出来满足他自己的需求和目的。当我们把未来的魔法棒制造产业变成一个集体事业,出于各种需求和目的的魔法棒都会被制造出来,使得世界上的魔法棒的能力能够更好的代表大众的需求。

就和民主一样。

尼古拉.特斯拉、亨利.福特、莱特兄弟和图灵大幅领先其他人,然后带来超前的改革,问题不大。但是当你的发明具有无法想象的力量的时候,你可不能让先驱们随便把东西造出来,这么搞就赌的太大了。

OpenAI致力于把人工智能的研发给民主化,让整个人类巨灵在先驱阶段就参于进来。埃隆是这么总结的:

“人工智能肯定会大幅的超越人类的智能。人工智能会与人类的意志息息相关,尤其是如果和很多人的意志相关的话,它产出的结果肯定也是很多人类所想要的,因为它会是集体人类意志的结果。”

所以,现在我们能让早期的人类级别或者高于人类级别的超级人工智能达到了民治和民享,这大大降低了人工智能被单个坏人或者一小撮垄断人群所掌控的机会。

现在我们要看看怎么做到民有。

这应该不难吧?人类巨灵创造超级人工智能的原因和创造汽车、工厂机械和计算机的目的是一样的,都是作为自身的延展,能把自身的一部分工作外包出去。汽车代替我们的双脚走路,工厂机械代替我们的双手工作,计算机则帮助我们储存信息、整理和计算。

造出能够思考的计算机会是我们至今为止最伟大的发明,它能帮我们把思考这个最重要也是影响力最大的工作也外包出去。思考是我们建造的一切东西的根源,想象一下,创造出一个超级智能的思想延展将会带来的力量。人类的延展从定义上来看肯定就是属于人类的,也就是民有,是不是?

并不是。

高端人工智能和其它的发明可不一样,其它的技术产物都很擅长服务那些它们被建造出来的目的,但是归根结底它们是没有思想、智能有限的机器。我们试图创造的人工智能会很聪明,像人一样聪明,甚至像一个极端聪明的人一样聪明。这在本质上和我们之前创造出来的东西是不一样的,我们不能默认原本的规则还会依然适用。

一直以来,我们创造出来的技术归属于我们,是件理所当然的事情,这个道理明显到把它写出来都显得有点多此一举。但是如果我们造出一个比人更聪明的东西,它会不会那么容易的被控制呢?

有没有可能,一个比地球上任何人类都更加聪明的东西,不会满足于一直作为人类的延展,即使这是它最初被创造出来的目的?

我们不知道最后事情会朝什么方向发展,但是承认这些可能性的存在是合乎逻辑的。

而如果事情真的朝我们担心的方向发展的话,那我们的麻烦就大了。

正如人类这个历史案例所揭示的,当这个星球上出现了一个比其它所有生物都聪明的东西的时候,它对于其它所有生物来说都是个很糟糕的事情。如果人工智能变成这个星球上比其它所有生物都更聪明的东西,而它并不是真正的属于我们,而是属于它自己的话,我们就变成了“其它所有生物”的一员了。

所以不让人工智能的力量落入一小撮垄断者手中确实是个问题,而OpenAI正是负责解决这个问题的。但是这个问题和人工智能不受人控制比起来就是小巫见大巫了。

这是让埃隆晚上难以入眠的困扰,在他看来超级人工智能的出现只是时间问题,而当这个时刻到来的时候,人类不沦落为“其它所有生物”的一员就变得至关重要了。

在一个由人工智能和“其它所有生物”组成的未来,我们只有一条出路:“变成人工智能。”